A deepfake hamisítással összekötött adathalászat mértéke a tavalyi évben rekordot döntve elképesztő mértékben nőtt. A szakértők véleménye szerint viszont csak most kezd majd igazán erősödni.

1988. - ebben az évben jelent meg a nagy sikerű PhotoShop képmanipulátor program első verziója, sokan a blog olvasói közül talán még meg sem születtek ekkor. A korábbi alapállás, amit persze a korabeli fényképek laboros hamisítása azért kicsit befolyásolt: lásd Sztálin féle retusált történelem, vagy a Loch Ness-i szörnyről, jetiről, bigfootról, ufókról készített állítólagos fotók - előtte azért mégiscsak az volt, hogy kevés kivételtől eltekintve hihetünk a szemünknek.

Ennek tette be a kaput látványosan a PhotoShop eleinte csak a címlapon szereplők megszépítésével, a későbbi tömeges használattal aztán már bármire és akármire használták, és persze az internetes csalásokban is kivette a részét.

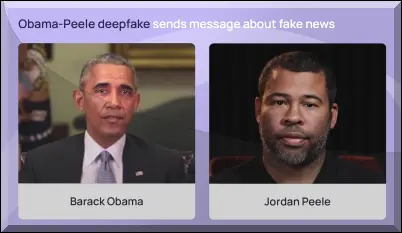

Bár csak 2017-ben jelent meg az első deepfake videó, ahol látszólag Obama beszélt, de egy másik ember tátogott a szájával, innentől aztán rohamtempóban felgyorsultak az események.

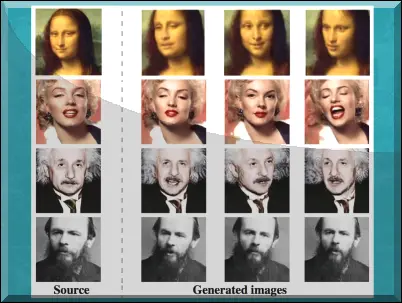

Az egyre jobb minőségű deepfake mellett a Samsung labor 2019-ben már egyetlen állóképből is tudott egyszerűen hamisított kezdetleges videót készíteni, amit szépen be is mutattak Mona Lisa, Einstein, Raszputyin, Salvador Dali és Marilyn Monroe főszereplésével.

Ez a technika hamarosan átverésekben, fakenews hírekben is felbukkant, például egy hamis Zelenszkij filmben, amiben látszólag a háború feladására szólított fel.

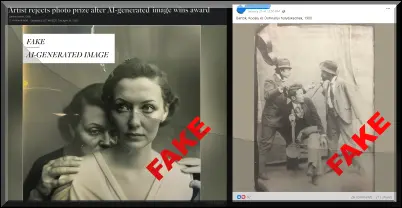

Állóképek terén is forradalmi változások jöttek a Dall-E, Tengr.ai, Midjourney, Leonardo.ai, Clipdrop, Wonder,

Stable Diffusion, Freepik, Dreamstudio és hasonló képgenerátoroknak köszönhetően, így láthattuk olyan soha meg nem történt eseményeket, mint a pufi-dzsekis Pápa, Trump tucatnyi rendőr általi letartóztatását, vagy robbantást a Fehér Házban.

A programok egyre komolyabb tudásúak, villámgyorsak és szinte bármit el lehet készíteni a segítségükkel.

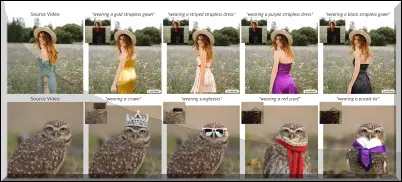

Végül pedig megérkezett a Google Lumiere és rövid idővel utána az OpenAI SORA alkalmazása, amely parancssor alapján már nem csak állóképet, hanem valósághű mozgó videót is képes generálni. Ezek tudásáról érdemes megnézni a bemutató videókat is, van ebben állókép egy részletének animálásától kezdve meglévő videó módosításán át prompt alapján készíthető élethű film is.

Bárkit érhet ilyen típusú hamisítás, például legutóbb Taylor Swift került a célkeresztbe, akinek a videójára ismeretlenek ráhamisítottak egy Trumpot éltető zászlót.

A gépi tanulással segített átverések már jó ideje egyre gyakoribbak lettek, és bár a fenti felsorolásból kimaradt a hang hamisítása, ez is már évek óta lehetséges, így például volt rá eset, hogy a DeepVoice hangszintetizálás segítségével 220 ezer euró összeget csaltak ki egy cég igazgatójától, és ebben magyar szál is szerepelt.

Sajnos a hétköznapokba is betört mindezt, például a klasszikus "öregezés" modernizált változatában a gyerek hangján hívják fel a szülőket, aki látszólag elmondja, hogy elrabolták és csak váltságdíj ellenében engedik szabadon.

A 2023. áprilisi esetnél szerencsére a dolog kamu volt, és az iskolás lány mindeközben egészségben és biztonságban síelt az osztálytársaival.

A mostani jelentés egybecseng az IT biztonsági cégek trendeket elemző korábbi éves jóslataival, ennek pedig az a fő oka, hogy mára már rengeteg ingyenes vagy igen olcsó fejlett mesterséges intelligencia-modell érhető el, amelyek használatához alig vagy egyáltalán nem szükséges semmilyen kódolási tudás.

Az AI használatával kapcsolatosan a fő félelem nem is az, hogy a Skynet egy napon majd öntudatra ébred és megöli Sarah Connort, hanem hogy a bűnözők egyre inkább rossz célokra használják.

A megelőzés-védekezés témához sok apró elemnek kellene a helyén lennie, elsősorban a biztonságtudatosság terén akár magánfelhasználókról, akár munkavállalókról beszélünk. Tisztában kell lenni az aktuális kockázatokkal, a fiókjainkban erős egyedi jelszó használat, kétfaktoros autentikáció elengedhetetlen, és segíthet az ismerkedés az AI alkalmazásokkal is, hogy lássuk, mire képesek ezek egyáltalán.

A nagy nyelvi modellekkel már nyelvtanilag közel hibátlan szövegeket lehet alkotni, így pusztán a helyesírás és nyelvhelyesség alapján egyre nehezebb a csalások egyszerű felismerése.

A gyanús, szokatlan, kéretlen megkeresések, a klasszikus sürgetés-fenyegetés mindenképpen intő jel kell, hogy legyen. A virtuális emberrablásnál pedig olyan nem közismert kérdések, mint korábbi családi eseményekre való utalás, a családon belül emlékezetes alkalmakra, időpontokra, ismerősökre való rákérdezés vagy előre megállapodott kulcsszavakra való hivatkozás segíthet a hanggal vagy videóval visszaélő csalók lebuktatásában.

Egy azonban biztos, egyre több kísérletet egyre nehezebb lesz majd a jövőben felismernünk.